| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- mybatis

- hadoop

- mapreduce

- 보조정렬

- plugin

- Express

- JavaScript

- IntelliJ

- Java

- R

- MSSQL

- es6

- SQL

- table

- Android

- react

- NPM

- Kotlin

- Python

- tomcat

- 공정능력

- GIT

- SPC

- Sqoop

- xPlatform

- Eclipse

- window

- vaadin

- SSL

- Spring

- Today

- Total

목록bigdata/kafka (5)

DBILITY

Confluent GitHub에서 ksql 4.1 release만 다운 받아 컴파일하고 실행해 보니 confluent-common, rest-utils 관련 패키지 오류가 발생했다. Confluent Platform의 OpenSource를 다운 받아 열어보니 거기에는 있었다. ksql에 대한 기대감이 크기도 하고, 이렇게 된 바에야 Confluent Platform에서 다운받아 쓰기로 한다. 헌데 거긴 zookeeper,kafka까지 모두 들어 있다. 오~마이~갓! docker도 써 볼겸 docker로 설치해 보자. docker는 https://docs.docker.com/install/linux/docker-ce/centos/를 참조해서 설치한다. [root@big-slave2 ~]# systemctl..

producer filebeat 테스트

producer filebeat 테스트

kafka를 data bus로 사용하고, hdfs 저장은 HDFSSinkConnector를 통해 저장할 수 있으니, producer로 flume agent를 사용하지 않더라도 경우에 따라선 filebeat으로 대체도 가능하겠다. 테스트에 필요한 로그데이터는 flume을 통해 생성해서 file_roll sink로 ./logdata 디렉토리에 저장한다. filebeat에서 log를 읽어 kafka out을 통해 kafka topic으로 보낸다. kafka 토픽생성 [kafka@big-slave4 ~]$ kafka-topics.sh \ --zookeeper big-master:2181,big-slave1:2181,big-slave2:2181/kafka-cluster \ --topic filebeat-topic..

flume kafka sink test ( 풀럼 카프카 싱크 테스트 )

flume kafka sink test ( 풀럼 카프카 싱크 테스트 )

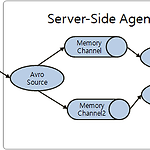

이전에 테스트했던 source에 sink를 추가해 보자. http://www.dbility.com/269 flume doc의 그림을 보고 memoryChannel2를 추가하고, kafkaSink에 연결하였다. kafka-manager에서도 Topic은 추가할 수 있다. Stream이 들어오는 중에 Topic에 partition을 하나씩 추가하고 reassign해보니 잘 된다.broker3개에 모두 할당했다. partition이 하나일때는 순서가 보장된다.그러나 partition이 늘어나면 당연한 얘기지만 partition내에서만 보장된다. kafka-console-consumer에서 확인해 보니, seq가 뒤죽박죽이다. collector나 server agent의 channel로 file도 테스트 해보니..

kafka-manager 설치

kafka-manager 설치

kafka-manager를 설치해 보자. 할 건 많고, 시간과 체력, 나의 뇌 성능으론 버겁다. 우리나라에선 철수한 Yahoo!!에서 만들었다. 이것도 철수네.철수가 참.. https://github.com/yahoo/kafka-manager/releases sbt build다. 2년전에 써보고 오랜만이다. 시간이 꽤 걸린다. [root@big-master ~]# adduser kafka; echo 'kafka' | passwd --stdin kafka; usermod -G datagroup kafka Changing password for user kafka. passwd: all authentication tokens updated successfully. [root@big-master ~]# cd ..

kafka cluster 로 big-slave2, big-slave3, big-slave4 에 3개를 설치해 본다. ssh인증부분은 없어도 될거 같은데...일단 복사문제, systemd 실행시 실행유저가 필요하니 추가함. #kafka cluster가 될 3대에 모두 추가 [root@big-slave2 ~]# useradd kafka ; echo 'kafka' | passwd --stdin kafka ; usermod -G datagroup kafka Changing password for user kafka. passwd: all authentication tokens updated successfully. [root@big-slave2 ~]# ssh big-slave3 "useradd kafka ; e..